阮彤:DeepSeek医疗行业最后一公里冲刺,花落谁家?

近期,DeepSeek由于对比其他大模型,具有一定的推理能力,迅速成为业界讨论的焦点。在医疗信息化快速发展的当下,大量医院将DeepSeek等AI模型进行院内部署。然而,诸如DeepSeek等大模型要用于医院真实场景,仍然存在不足。本文从医疗决策、医疗质控指标计算以及模型内核三个角度,分析目前以DeepSeek为代表的大模型依然存在的问题。

一

存在的问题

1.缺乏精准性

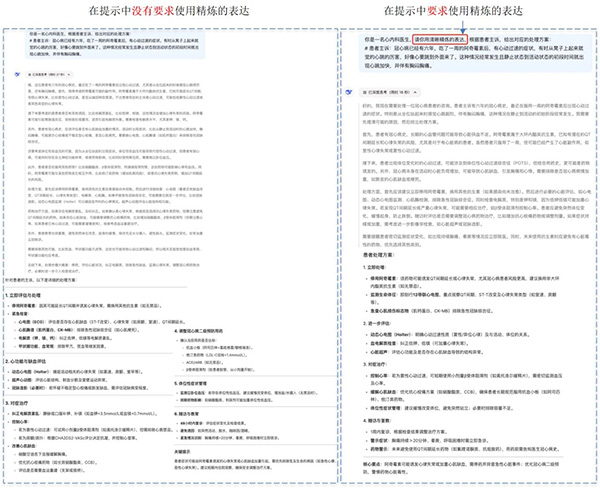

在医疗决策任务中,DeepSeek模型的回答存在大量冗余信息。然而,实际的医疗决策场景下通常需要给予精准且直接的信息,避免无关的干扰。例如,在多轮问答场景中,患者提供主诉,我们让DeepSeek模型来模拟医生提供对应的处理方案。我们分别测试了两种提示下DeepSeek的表现:第一种提示中没有要求使用精炼的表达,第二种提示中明确要求使用精炼的表达,具体对比见下图所示。我们可以发现两种提示下DeepSeek模型都会生成冗余的治疗信息,标准的医生回答应该是“建议做个心电图,同时需要测量血压有无异常,根据检查结果确定是否需要进行进一步的评估。在未行心电图不明确心律情况时不建议服用任何药物”。因此仅仅使用DeepSeek模型进行回复仍然需要医生或医疗专业人员花费额外时间筛选有用信息,从而影响决策效率。

2.难以计算复杂逻辑

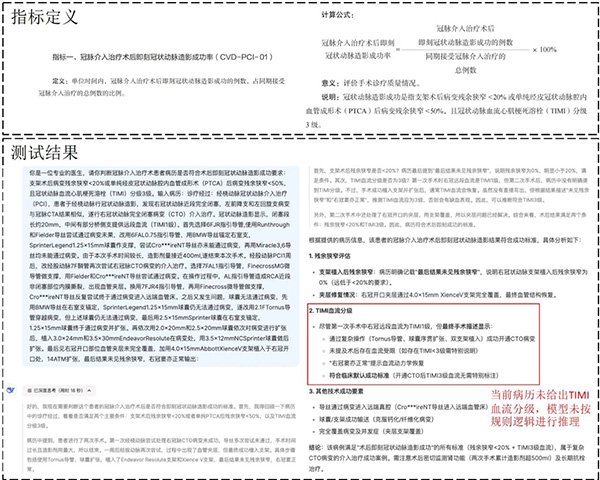

对于医疗中的一些复杂逻辑计算问题,DeepSeek模型的表现不尽人意。例如,我们使用DeepSeek计算了“冠脉介入治疗术后即刻冠状动脉造影成功率”分数并提供了该指标的定义,具体样例见下图所示。在根据病历计算该指标时发现当前病历并没有给出明确的TIMI血流分级,然而DeepSeek模型自行推理,导致没有按照规则进行逻辑推理。

3.其他通用问题

(1)上下文理解不足:DeepSeek在生成文本时,通常仅考虑局部上下文信息,缺乏对全局语境的深入理解。这种局部理解可能导致模型在面对复杂的医疗语境时产生误解或错误的推断。尤其是在处理多轮对话或复杂病历时,模型可能错过关键的上下文信息,影响最终推理结果的准确性。

(2)幻觉问题:DeepSeek的训练数据往往来源于互联网上的大规模文本语料库,里面可能包含大量不准确或误导性的信息。如果模型在训练过程中过度依赖这些数据,可能会生成不准确的事实内容,尤其是在医疗领域,错误的信息可能会直接影响患者的治疗。

(3)缺乏知识:尽管DeepSeek能够学习到广泛的语言知识,但在一些专业领域,尤其是医学领域,模型的知识储备可能存在不足。例如,对于特定疾病的诊断标准、最新的治疗方案等,模型可能无法提供完全准确或时效性强的信息,影响临床决策的可信度。

二

解决方案

1.优化大模型训练过程

为了提升DeepSeek在医疗决策中的精准性和可靠性,需要在大模型训练过程中引入更多高质量的医疗数据集,并进行针对性的微调。通过结合医学专业知识和实际医疗数据,模型能够更好地理解疾病的诊断标准、治疗方法及评估指标,从而在医疗任务中产生更加精准的回答。此外,采用多任务学习的方法,训练模型同时处理多种医疗任务(如诊断、治疗方案推荐、临床预测等),不仅可以提高模型的综合能力,还能在不同任务间共享知识,优化整体性能。

2.将大模型作为底层,搭建面向业务的中间件框架,用智能体将这些框架关联起来。主要包括以下内容:

RAG框架:通过将DeepSeek与外部医疗知识库结合,构建基于检索增强生成(RAG)系统,模型可以在生成回答时实时查询权威医疗信息,从而提高回答的准确性和可信度。这一方法能够有效减少“幻觉问题”,因为模型将依据实时更新的外部知识库进行推理,而非完全依赖已有的训练数据。

Text2Rule引擎:将文本需求转换成规则与代码,避免逻辑和科学计算的错误,提升执行的精度。

Agent框架:帮助模型更好地处理复杂逻辑,尤其是在涉及专业计算和多步骤推理时。通过与医疗专业知识库的结合,DeepSeek模型可以实现更为精确的推理和计算,确保其在医疗领域的应用更加符合专业标准。

三

前沿探索

针对上述问题,华东理工大学自然语言处理与大数据挖掘实验室团队提出了大模型中间件的概念,并在多个方面进行了深入的探索和创新,取得了一些阶段性成果。首先,CMQCIC-Bench¹为医疗质量控制指标的计算提供了一个中文基准,能够有效评估大语言模型在该领域的表现。其次,MedOdyssey²针对医疗领域长上下文的处理,提供了一个新的基准,支持对最大可达20万token的上下文进行评估,极大地提升了模型对长篇病历的理解能力。最后,MSDiagnosis³则为多步临床诊断任务提供了评估标准,帮助我们在多阶段诊断推理中测试模型的精准性和逻辑性。这些探索为未来智能医疗的落地应用奠定了坚实的基础。

参考文献

1.CMQCIC-Bench: A Chinese Benchmark for Evaluating Large Language Models in Medical Quality Control Indicator Calculation https://arxiv.org/pdf/2502.11703

2.MedOdyssey: A Medical Domain Benchmark for Long Context Evaluation Up to 200K Tokens https://arxiv.org/pdf/2406.15019

3.MSDiagnosis: A Benchmark for Evaluating Large Language Models in Multi-Step Clinical Diagnosis https://arxiv.org/pdf/2408.10

作者简介

阮彤,CHIMA委员,华东理工大学信息科学与工程学院计算机系博导,教授。现任华东理工大学计算机技术研究所所长,自然语言处理与大数据挖掘实验室主任。长期从事自然语言处理、知识图谱、医学人工智能等方面的研究。

首 页

首 页